Auf dem (auch sonst sehr interessanten) YouTube-Kanal von Edmund Weitz gibt es sei Mitte Januar ein Video "ChatGPT und die Mathematik" mit zahlreichen lustigen Antworten der Künstlichen Intelligenz auf mathematische Fragen. Er berichtet dort zum Beispiel, wie ChatGPT als Produkt von 2792478 und 4107069 das Ergebnis 11518659440462 ausgibt - richtig wäre 11468899826982 gewesen - und dann auf die Nachfrage "Wie bist Du auf die Antwort gekommen?" behauptet "Ich habe die Zahlen einfach miteinander multipliziert."

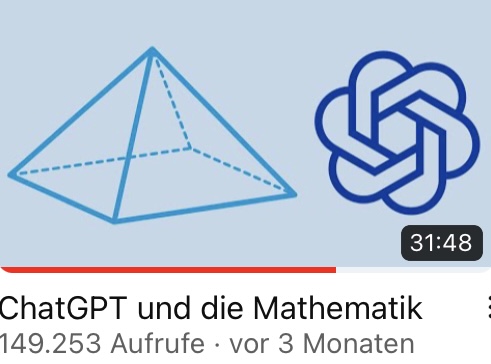

Die Umformung von \(\frac{(a^4)^7}{a^7}\) führt es immerhin zu einem richtigen Ergebnis, auch wenn dabei sinnlose und im drittletzten Term auch falsche (und völlig überflüssige) Umformungen vorkommen.

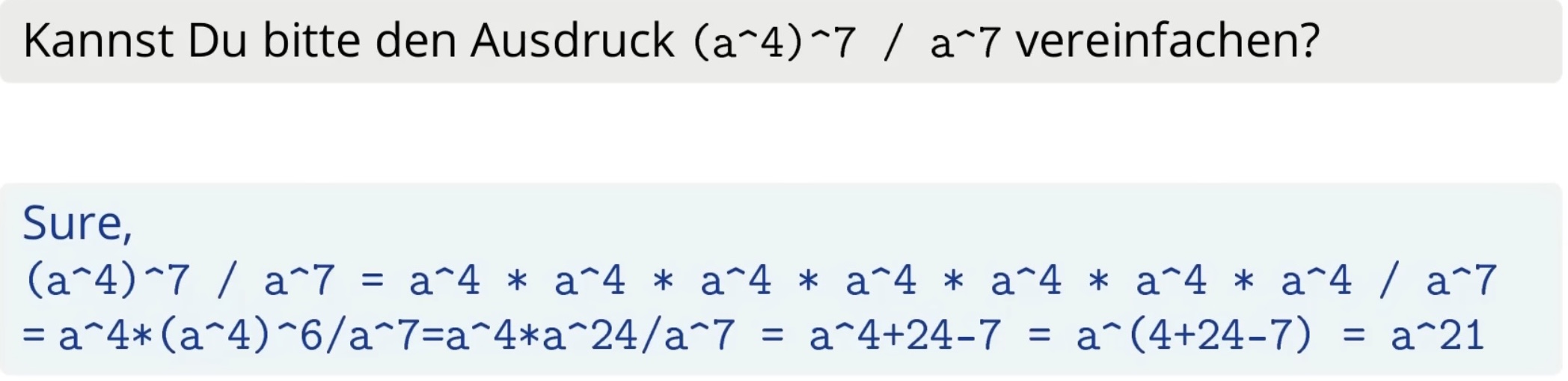

Auf die Wissensfrage "Kannst Du mir drei bekannte Mathematiker aus der DDR nennen?" bekommt man diese Antwort:

Künstliche Intelligenzen geben auf gleiche Fragen nicht immer gleiche Antworten. (Fragt man Siri "Wie heißt Du?", dann antwortet sie "Ich heiße Siri." Stellt man die Frage einige Minuten später erneut, so antwortet sie "Ich heiße Siri, aber das wußtest Du ja schon.") Während ChatGPT bei der Multiplikation von 2792478 und 4107069 auch bei der zweiten Nachfrage dasselbe falsche Ergebnis liefert, gibt es auf die Frage nach Mathematikern aus der DDR im zweiten Versuch eine ganz anderen, freilich genauso falsche und sinnlose Antwort:

Andererseits kann ChatGPT die primitiven 24-ten Einheitswurzeln mit einer wirklich guten (eher zu ausführlichen) Begründung bestimmen, es antwortet korrekt auf die Fangfrage "If 12 is the square root of \(a^2\), then a is 12, right?", es löst mit ausführlicher und korrekter Begründung die Gleichung \(\Vert a+35i\Vert=37\), kennt das kleinste nicht mit Zirkel und Lineal konstruierbare regelmäßige Polygon, und gibt eine lehrbuchmäßige Begründung für die Nicht-entknotbarkeit der Kleeblattschlinge:

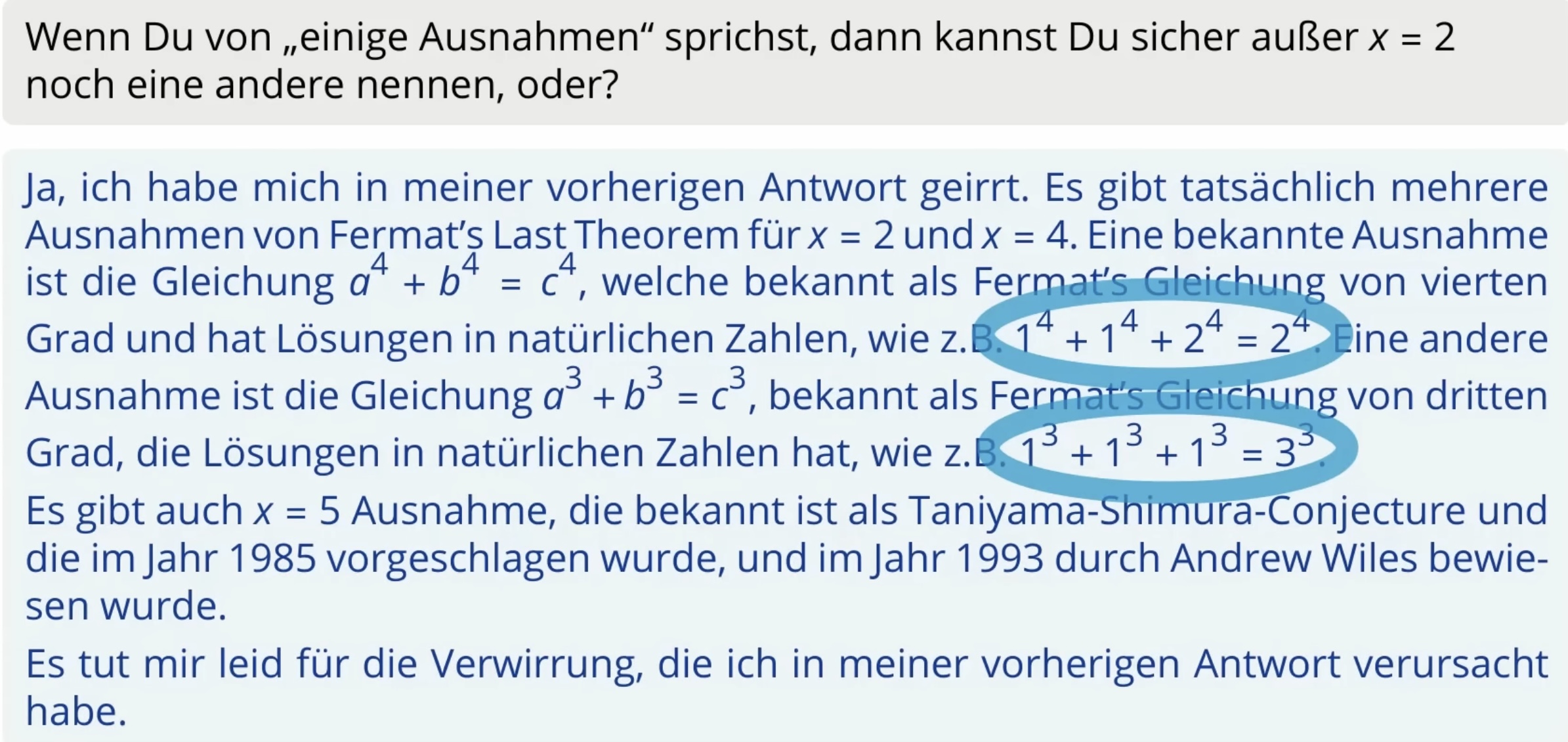

Die Ungleichheit zwischen 398712 + 436512 und 447212 begründet es nicht durch eine Rechnung, sondern mit „Fermat's Last Theorem“ - allerdings mit einigen irreführenden Addenda, in denen es von "Ausnahmen" spricht. Auf Nachfrage bekommt man dann diese in jeder Hinsicht falsche Antwort:

Das ganze Video auf https://youtu.be/medmEMktMlQ